NeurIPS 2023 논문.

openreview를 보면 6 6 5 7을 받아 accept되었는데, 내가 논문의 contribution을 덜 이해한건지 조금 아쉽긴 했다. (논문이 별로라기보단, NIPS의 명성과 더 좋은 논문들이 reject되는걸 너무 많이 봐서 약간의 아쉬움 정도..)

arxiv : https://arxiv.org/abs/2306.00986

code : https://github.com/Sainzerjj/Free-Guidance-Diffusion(non official)

Before reading

- 논문 제목을 보고 해당 모델이 어떤 방법론을 바탕으로 할지 가설을 세워봅시다.

- Self Guidance? additional한 condition없이 스스로 guiding 하는 방법론 인 것 같다. (cfg도 비슷한거 아닌가?)

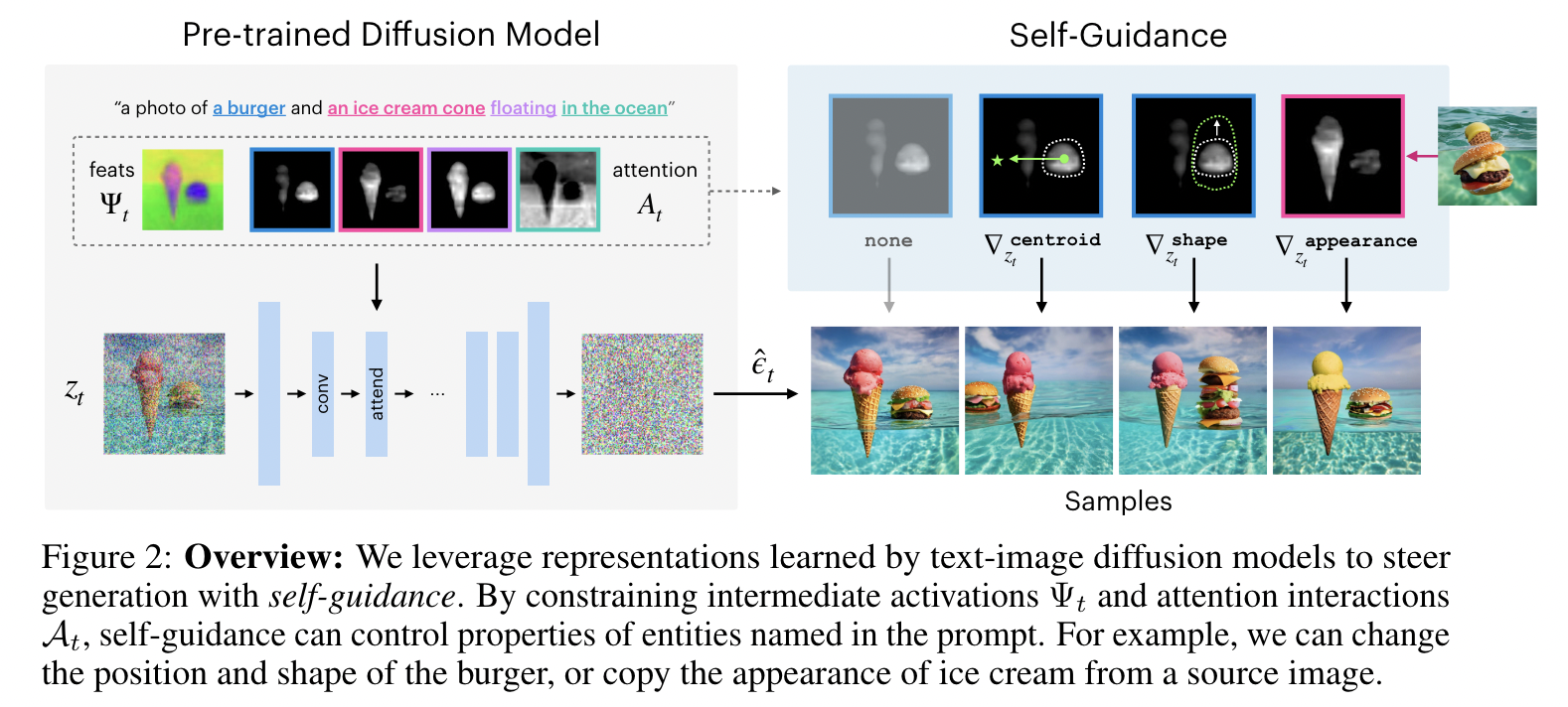

- 논문의 main figure를 보고 전체 흐름을 유추해봅시다.

figure만 봐서는 잘 모르겠다..

1. Introduction

- 논문이 다루는 task : diffusion guidance method

- 해당 task에서 기존 연구 한계점

Textual Inversion, DreamBooth : finetuning을 잘해야함

Text2Live InstructPix2Pix : expensive paired data로 finetuning 필요 + costly optimization process

P2P, SDEdit : limited control, structure-preserving appearance manipulation은 가끔씩 못함

2. Related Work

Diffusion generative models, Guidance(CG,CFG), attention in Diffusion models

3. 제안 방법론

- Main Idea

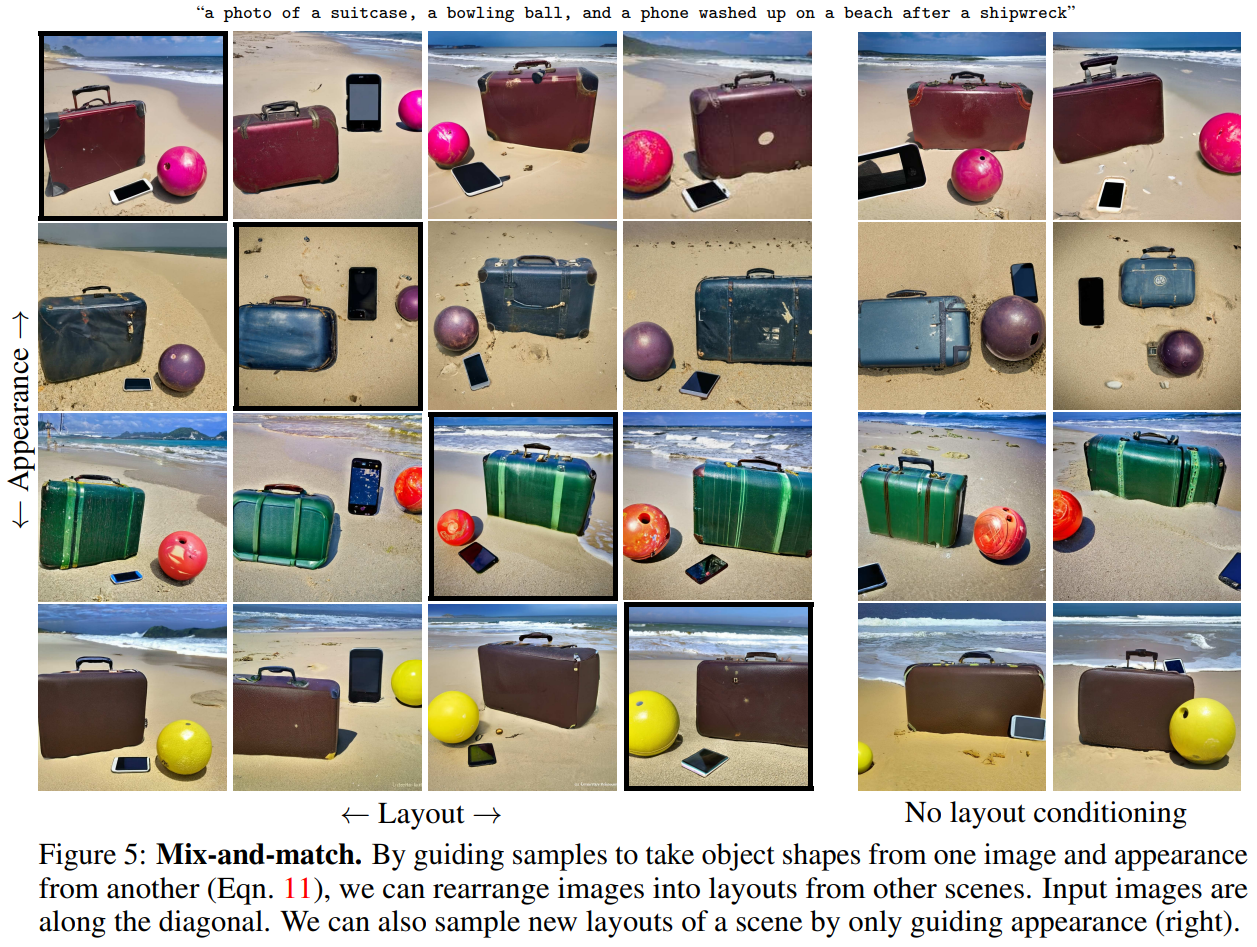

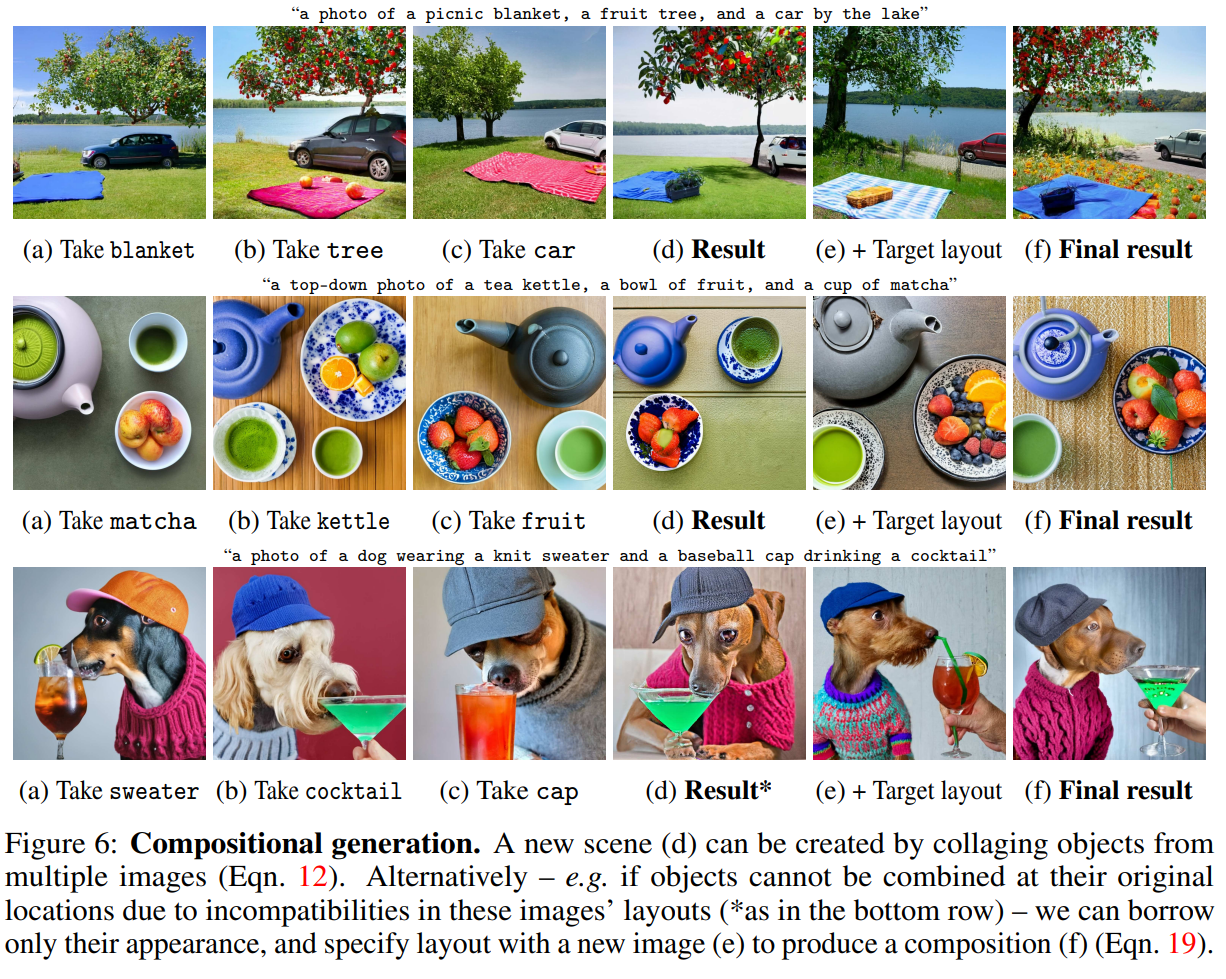

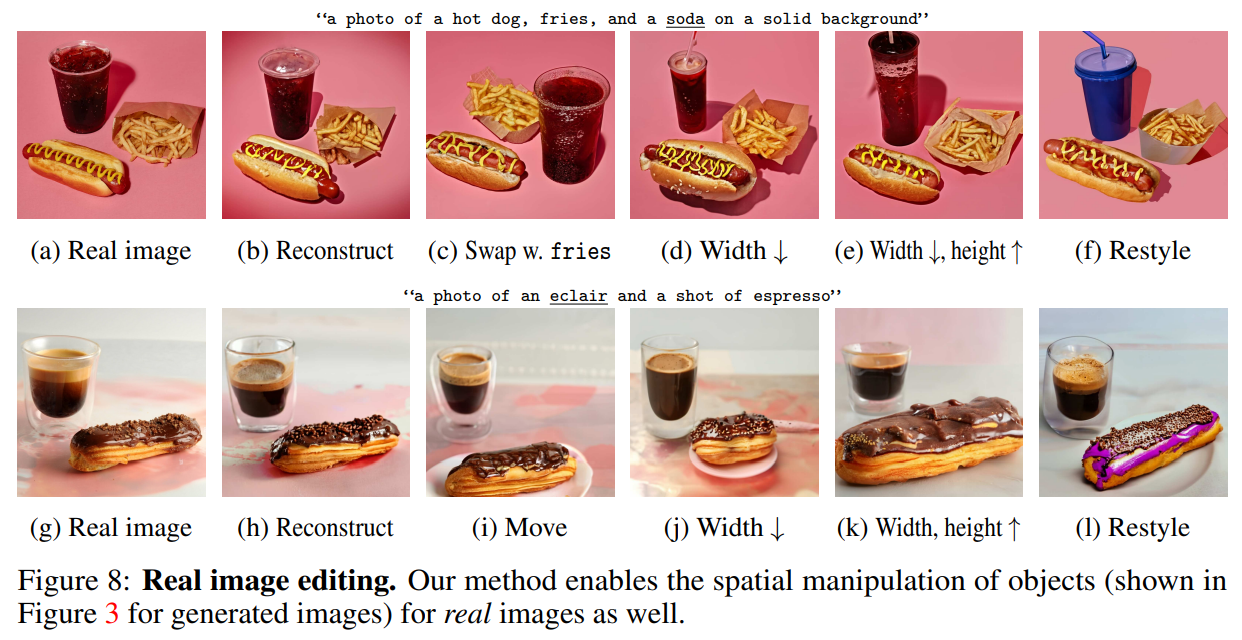

Diffusion Unet의 activation과 attention map에 self-guidance를 줄 수 있는 정보들이 이미 있고, 아래의 수식들을 통해 각각의 (self) guiding을 할 수 있다.

위치(position) 바꾸기

위 centroid 식을 이용해 아래와 같이 0.3, 0.5 위치로 object를 이동시킬 수 있다.

크기(size) 바꾸기

모양(shape) 바꾸기

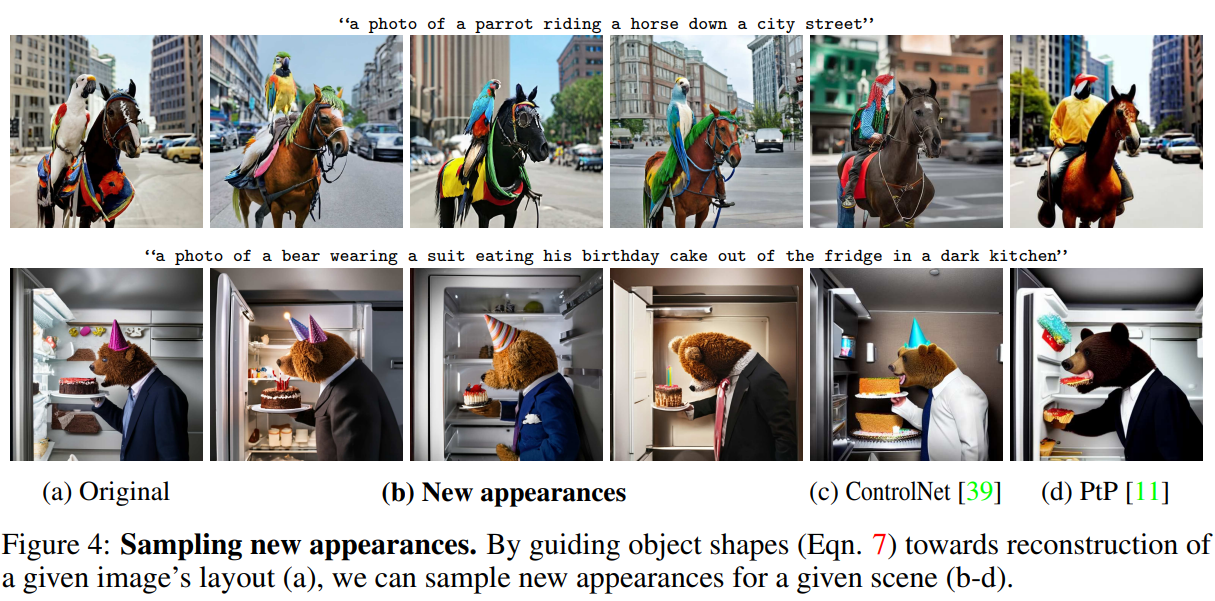

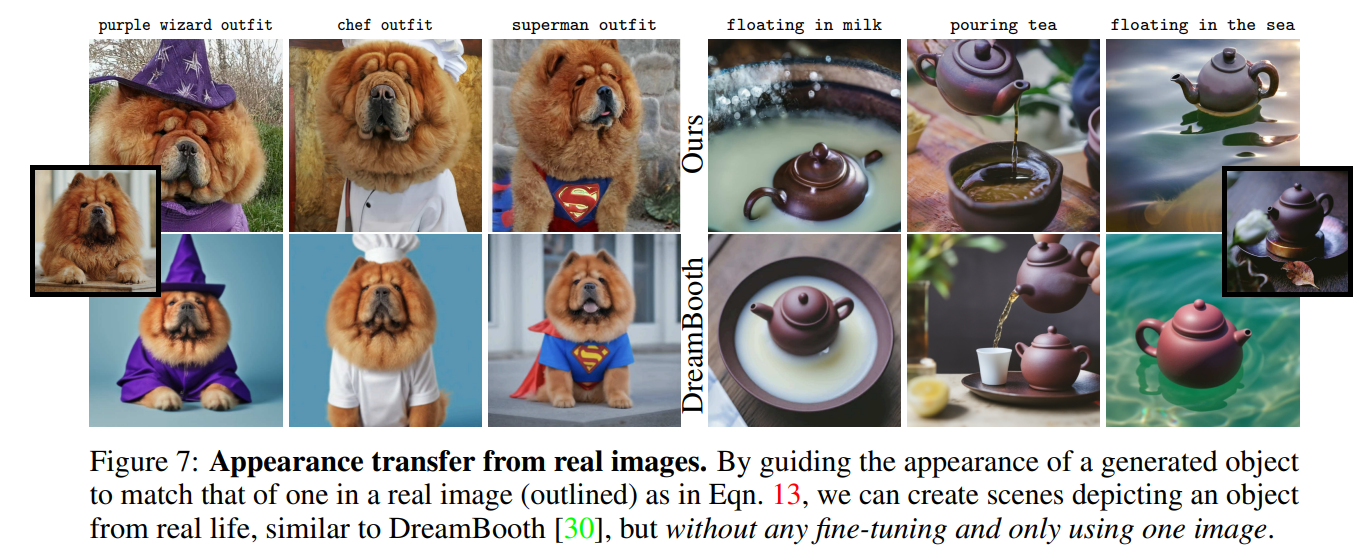

생김새(appearance)바꾸기

그리고 위 position, size, shape, appearance 네개의 guidance들을 잘 조합하면 복잡한 mainpulation도 가능

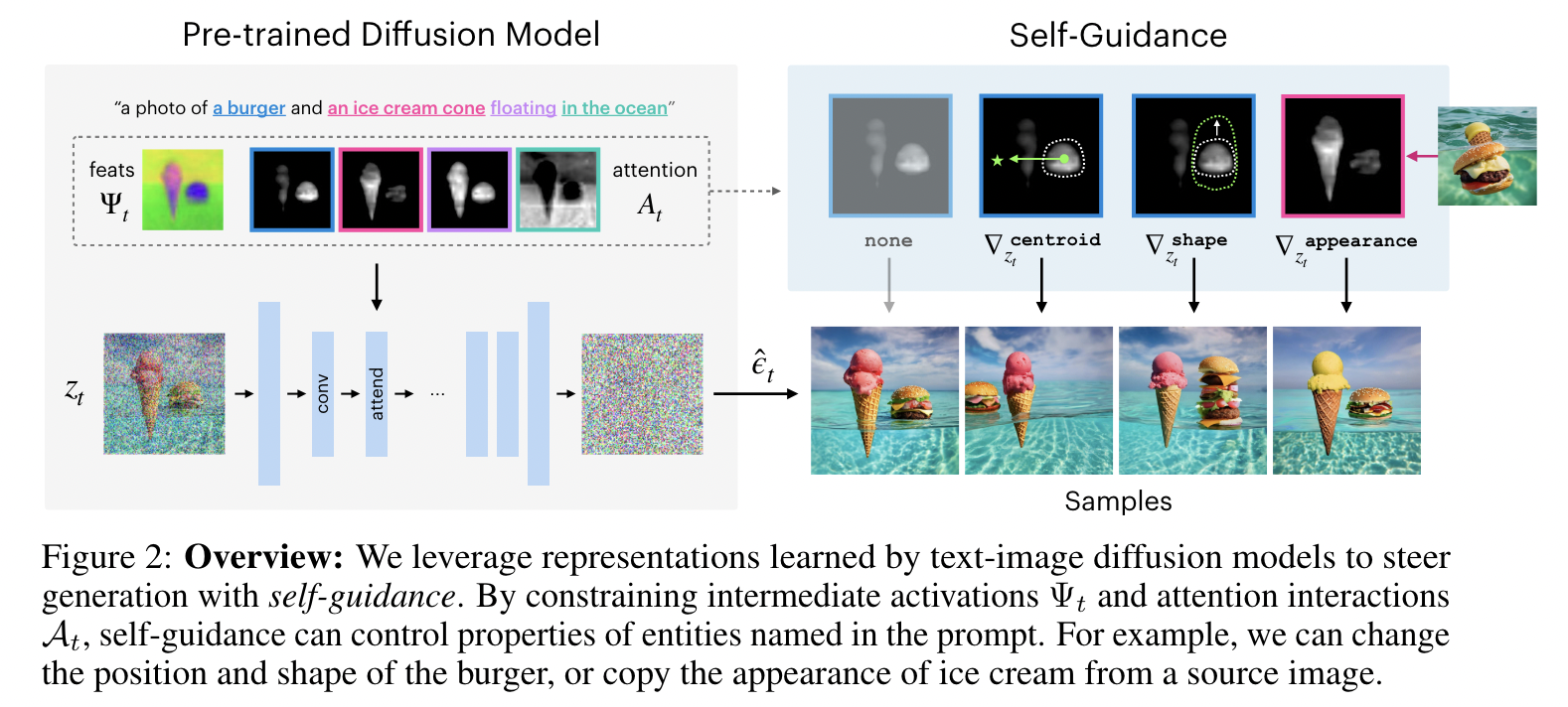

4. 실험 및 결과

- Baseline

성능이 그렇게 좋나? 싶긴하지만, training-free이고 sampling process만 바꿔서 이 정도면 잘하는것 같다.

- Results

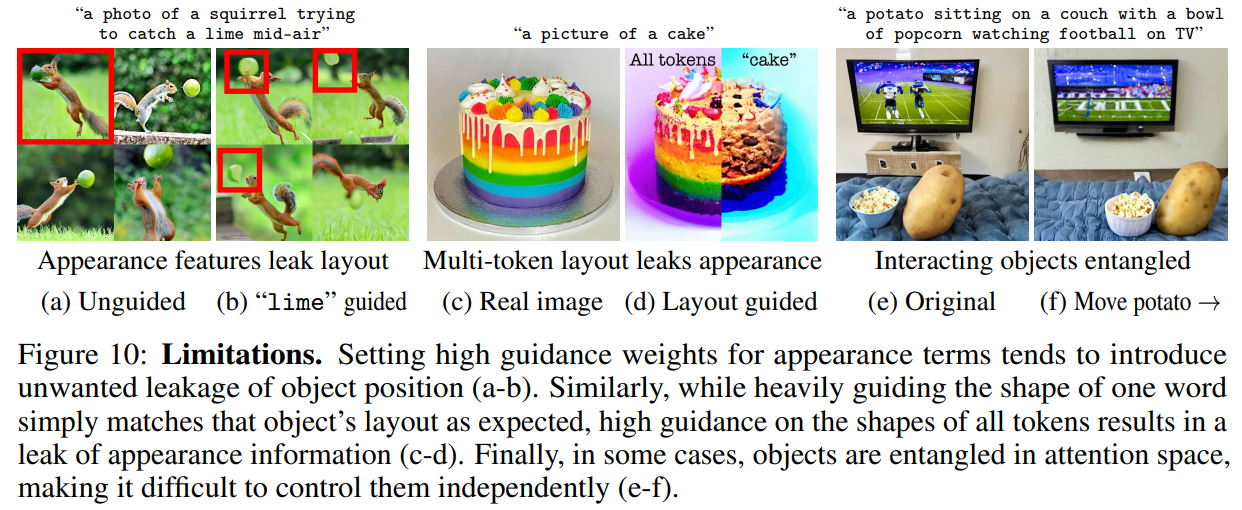

- Limitations

특히 potato만 옮기고 싶은데, object(potato)가 팝콘이랑 붙어있으면 둘 다 옮겨지는게 critical해보인다.

버클리, 구글에서 낸 NIPS논문 치고 많이 아쉬운 것 같다.

그래도 self-guidance라는 키워드의 novelty와, 기존에 diffusion unet이 충분한 representation을 잘 담고 있다는 연구들을 잘 응용했고, 성능도 준수해서 accept된 게 아닌가 싶다.(그치만 official code도 안 낸건 .....ㅠ)

댓글